Samova dobrodružství už si zahrálo přes 11000 dětí

06. 10. 2025

Zahrajte si ji i vy a naučte se něco nového! http://sam.e-bezpeci.cz/

Zaktualizovali jsme web věnovaný mediální výchově

05. 10. 2025

Zaktualizovali jsme pro vás náš web věnovaný mediální výchově! Nově v něm najdete části věnované např. manipulaci v reklamě, stereotypy v médiích...

E-Bezpečí na WhatsAppu

25. 09. 2025

Máte WhatsApp? My taky! Sledujte náš kanál na této populární platformě.

Přečteno jinde

Podpořte nás

Podpořte naše aktivity a pomozte dětem a dospělým v nouzi. Již 15 let pomáháme dětem a dospělým řešit jejich problémy na internetu. Zapojte se i vy! Každá pomoc se počítá! Stačí kliknout na tlačítko DONATE.Přihlásit odběr novinek

Hráči v ohrožení: 10 největších rizik online hraní a jak se jim bránit

Online hry jsou dnes obrovským fenoménem. Mnoho dětí i dospělých tráví hodiny u populárních titulů jako GTA, Minecraft nebo Call of Duty. Herní svět ale není jen místem zábavy – čím víc lidí hraje, tím více se o hráče zajímají kyberzločinci. Podle odborníků z Kaspersky využívají útočníci různé triky, aby získali herní účty, osobní data a peníze. V posledních letech se počet útoků dramaticky zvýšil. Pojďme se podívat na 10 nejčastějších rizik, která na hráče číhají, a na nejnovější trendy v kyberútocích.

Online hry jsou dnes obrovským fenoménem. Mnoho dětí i dospělých tráví hodiny u populárních titulů jako GTA, Minecraft nebo Call of Duty. Herní svět ale není jen místem zábavy – čím víc lidí hraje, tím více se o hráče zajímají kyberzločinci. Podle odborníků z Kaspersky využívají útočníci různé triky, aby získali herní účty, osobní data a peníze. V posledních letech se počet útoků dramaticky zvýšil. Pojďme se podívat na 10 nejčastějších rizik, která na hráče číhají, a na nejnovější trendy v kyberútocích.

E-Bezpečí spouští aktualizovanou verzi online videokurzu o umělé inteligenci pro učitele

Projekt E-Bezpečí zveřejnil zbrusu aktualizovanou verzi svého online videokurzu o umělé inteligenci, který je určen především učitelům základních a středních škol, ale také všem dalším zájemcům o problematiku AI. Kurz se zaměřuje na praktické využití moderních nástrojů umělé inteligence ve vzdělávání i na bezpečnostní rizika, která jsou s AI spojena. Kurzem provází prof. Kamil Kopecký, vedoucí projektu E-Bezpečí a ředitel Institutu výzkumu a vývoje v oblasti digitálních technologií a kyberkriminality na Pedagogické fakultě Univerzity Palackého v Olomouci. Díky jeho dlouholetým zkušenostem v oblasti bezpečnosti dětí v online prostředí i moderních digitálních technologií nabízí kurz nejen teoretické základy, ale především praktické rady a doporučení. Videokurzem již prošly tisíce učitelů z celé České republiky, kteří díky němu získali jistotu v práci s AI a inspiraci pro inovace ve výuce.

Projekt E-Bezpečí zveřejnil zbrusu aktualizovanou verzi svého online videokurzu o umělé inteligenci, který je určen především učitelům základních a středních škol, ale také všem dalším zájemcům o problematiku AI. Kurz se zaměřuje na praktické využití moderních nástrojů umělé inteligence ve vzdělávání i na bezpečnostní rizika, která jsou s AI spojena. Kurzem provází prof. Kamil Kopecký, vedoucí projektu E-Bezpečí a ředitel Institutu výzkumu a vývoje v oblasti digitálních technologií a kyberkriminality na Pedagogické fakultě Univerzity Palackého v Olomouci. Díky jeho dlouholetým zkušenostem v oblasti bezpečnosti dětí v online prostředí i moderních digitálních technologií nabízí kurz nejen teoretické základy, ale především praktické rady a doporučení. Videokurzem již prošly tisíce učitelů z celé České republiky, kteří díky němu získali jistotu v práci s AI a inspiraci pro inovace ve výuce.

Deep nudes: nebezpečný fenomén umělé inteligence, který zasahuje i děti

Umělá inteligence se stala běžnou součástí našich životů – pomáhá nám překládat texty, vytvářet obrázky či plánovat úkoly. S jejím rychlým rozvojem se však objevují i nové hrozby, které jsme si ještě před pár lety neuměli představit. Jednou z nejzávažnějších je fenomén zvaný deep nudes. Jde o falešné nahé fotografie vytvořené umělou inteligencí z běžných snímků lidí. Tento trend se bohužel netýká jen dospělých, ale stále častěji zasahuje také děti a dospívající. Dopady na psychiku obětí mohou být ničivé.

Umělá inteligence se stala běžnou součástí našich životů – pomáhá nám překládat texty, vytvářet obrázky či plánovat úkoly. S jejím rychlým rozvojem se však objevují i nové hrozby, které jsme si ještě před pár lety neuměli představit. Jednou z nejzávažnějších je fenomén zvaný deep nudes. Jde o falešné nahé fotografie vytvořené umělou inteligencí z běžných snímků lidí. Tento trend se bohužel netýká jen dospělých, ale stále častěji zasahuje také děti a dospívající. Dopady na psychiku obětí mohou být ničivé.

Rizika spojená s kanály na WhatsApp

Populární messenger WhatsApp už dávno není jen prostředkem pro zasílání zpráv mezi kamarády. Uživatelé využívají také skupiny a od roku 2023 i tzv. kanály — formy komunikace, kde jeden či více autorů sdílí obsah a sledující mohou reagovat. Pro děti je to přitažlivé: možnost sledovat trendová videa, získávat pozornost, bavit se s vrstevníky... a mít dosah měřitelný počty followerů a lajky/srdíčky či v případě WhatsAppu lilky. Ale právě tady číhají nebezpečí — často skrytá, ale velmi reálná.

Populární messenger WhatsApp už dávno není jen prostředkem pro zasílání zpráv mezi kamarády. Uživatelé využívají také skupiny a od roku 2023 i tzv. kanály — formy komunikace, kde jeden či více autorů sdílí obsah a sledující mohou reagovat. Pro děti je to přitažlivé: možnost sledovat trendová videa, získávat pozornost, bavit se s vrstevníky... a mít dosah měřitelný počty followerů a lajky/srdíčky či v případě WhatsAppu lilky. Ale právě tady číhají nebezpečí — často skrytá, ale velmi reálná.

Když nám AI říká, že nás chápe. O iluzi přátelství s chatboty

Chatboti s umělou inteligencí už dávno nejsou jen pomocníci. Stávají se společníky, přáteli – a někdy dokonce partnery. Co se může jevit jako útěcha pro osamělé, může být problém pro děti a dospívající. AI nás nikdy neodmítne. Ale skutečný život takový není. Míříme do budoucnosti, kde bude snazší milovat stroj než člověka?

Chatboti s umělou inteligencí už dávno nejsou jen pomocníci. Stávají se společníky, přáteli – a někdy dokonce partnery. Co se může jevit jako útěcha pro osamělé, může být problém pro děti a dospívající. AI nás nikdy neodmítne. Ale skutečný život takový není. Míříme do budoucnosti, kde bude snazší milovat stroj než člověka?

E-Bezpečí vydává novou vzdělávací hru pro žáky ZŠ!

E-Bezpečí Pedagogické fakulty Univerzity Palackého v Olomouci spouští novou vzdělávací počítačovou hru Samova dobrodružství I: Trable ve škole, která je určena především žákům základních škol (od cca 4.-5. třídy ZŠ). Hra zábavnou a interaktivní formou seznamuje děti se základy online bezpečnosti a učí je, jak se správně chovat v digitálním prostředí. Hru si můžete zahrát v prohlížeči a je zcela zdarma.

GPT-5: Nový model umělé inteligence s ambicemi, ale i limity

Společnost OpenAI v srpnu 2025 představila svůj nejnovější model GPT-5, který se okamžitě stal výchozím jádrem ChatGPT i dalších služeb. Novinka přichází s ambicí propojit předchozí generace modelů do jednotného systému, jenž se dokáže automaticky rozhodovat, kdy použít rychlejší, a kdy naopak důkladnější a pomalejší režim práce. Uživatel tak nemusí manuálně přepínat mezi různými modely – vše probíhá na pozadí.

Společnost OpenAI v srpnu 2025 představila svůj nejnovější model GPT-5, který se okamžitě stal výchozím jádrem ChatGPT i dalších služeb. Novinka přichází s ambicí propojit předchozí generace modelů do jednotného systému, jenž se dokáže automaticky rozhodovat, kdy použít rychlejší, a kdy naopak důkladnější a pomalejší režim práce. Uživatel tak nemusí manuálně přepínat mezi různými modely – vše probíhá na pozadí.

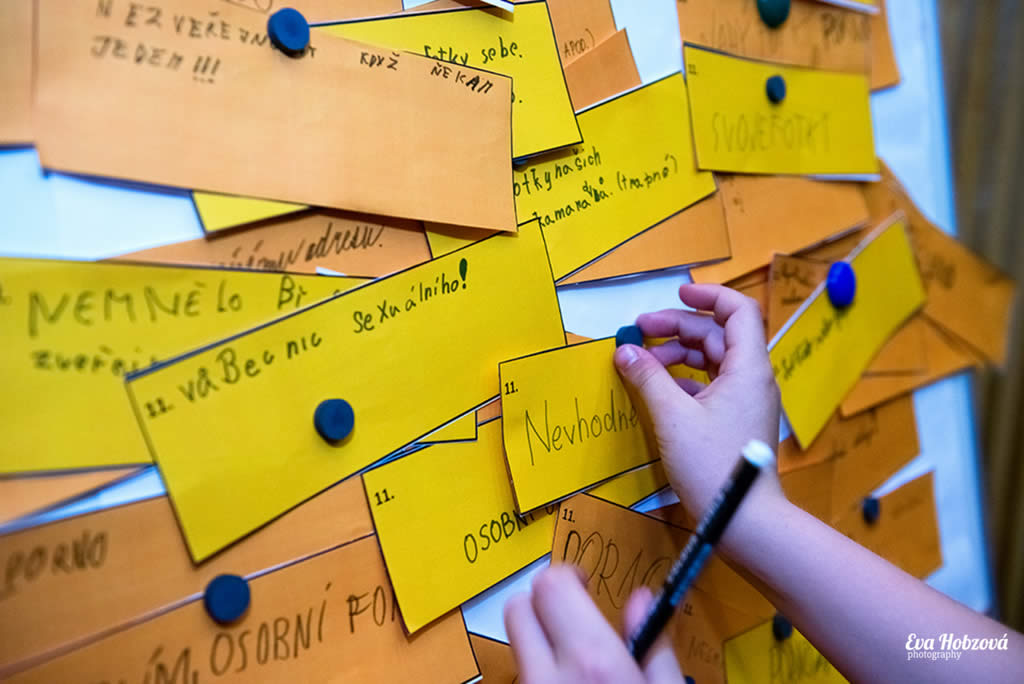

Prevence rizikového chování musí cílit na dospělé!

Ve většině českých škol se dnes žáci nějakým způsobem učí, jak se bránit kyberšikaně či kybergroomingu, jak nakládat se svými osobními údaji a chránit si své účty, případně se seznamují s tím, jak fungují online podvody a na co si dát pozor. Dospělí však často zůstávají bez jakékoli prevence. Výsledkem jsou časté podvody, ztráty celoživotních úspor a bezradnost obětí. Proč na vzdělávání dospělých v oblasti kybernetické bezpečnosti zapomínáme?

Ve většině českých škol se dnes žáci nějakým způsobem učí, jak se bránit kyberšikaně či kybergroomingu, jak nakládat se svými osobními údaji a chránit si své účty, případně se seznamují s tím, jak fungují online podvody a na co si dát pozor. Dospělí však často zůstávají bez jakékoli prevence. Výsledkem jsou časté podvody, ztráty celoživotních úspor a bezradnost obětí. Proč na vzdělávání dospělých v oblasti kybernetické bezpečnosti zapomínáme?

Digitální stopa – co to je a proč je důležité ji chránit

Digitální stopa je souhrn všech informací, které o nás zůstávají v online prostředí v důsledku naší aktivity na internetu. Patří sem nejen příspěvky, fotografie, videa či komentáře, které sami zveřejníme na sociálních sítích, ale také data, která se o nás shromažďují automaticky – například vyhledávací historie, údaje o poloze, informace z mobilních aplikací a malé soubory zvané cookies, které zaznamenávají, jaké weby navštěvujeme a co na nich děláme. Digitální stopu vytváříme vědomě i nevědomě a její rozsah se neustále zvětšuje.

Digitální stopa je souhrn všech informací, které o nás zůstávají v online prostředí v důsledku naší aktivity na internetu. Patří sem nejen příspěvky, fotografie, videa či komentáře, které sami zveřejníme na sociálních sítích, ale také data, která se o nás shromažďují automaticky – například vyhledávací historie, údaje o poloze, informace z mobilních aplikací a malé soubory zvané cookies, které zaznamenávají, jaké weby navštěvujeme a co na nich děláme. Digitální stopu vytváříme vědomě i nevědomě a její rozsah se neustále zvětšuje.

Dusting Challenge

Na TikToku se šíří další nebezpečná virální výzva. Takzvaná „Dusting Challenge“ motivuje mladé uživatele k vdechování plynu ze sprejů běžně dostupných v domácnostech - třeba sprejů na čištění klávesnic a počítačů. Lékaři i odborníci na závislosti varují před vážnými zdravotními důsledky, včetně poškození mozku, selhání srdce i smrti.

Na TikToku se šíří další nebezpečná virální výzva. Takzvaná „Dusting Challenge“ motivuje mladé uživatele k vdechování plynu ze sprejů běžně dostupných v domácnostech - třeba sprejů na čištění klávesnic a počítačů. Lékaři i odborníci na závislosti varují před vážnými zdravotními důsledky, včetně poškození mozku, selhání srdce i smrti.

101 způsobů, jak využít umělou inteligenci ve školství

Umělá inteligence (AI) už dávno není jen futuristickým pojmem – stává se každodenním pomocníkem učitelů, studentů i školních administrátorů. A právě proto vznikla unikátní příručka „Jak využít AI (nejen) ve školství – 101 tipů“, kterou připravil Karel Klatovský, expert na technologie ve vzdělávání a dlouholetý pedagog.

Umělá inteligence (AI) už dávno není jen futuristickým pojmem – stává se každodenním pomocníkem učitelů, studentů i školních administrátorů. A právě proto vznikla unikátní příručka „Jak využít AI (nejen) ve školství – 101 tipů“, kterou připravil Karel Klatovský, expert na technologie ve vzdělávání a dlouholetý pedagog.

Nejčtenější články za posledních 60 dní

Když nám AI říká, že nás chápe. O iluzi přátelství s chatboty

E-Bezpečí vydává novou vzdělávací hru pro žáky ZŠ!

Rizika spojená s kanály na WhatsApp

Prevence rizikového chování musí cílit na dospělé!

E-Bezpečí spouští aktualizovanou verzi online videokurzu o umělé inteligenci pro učitele

E-Bezpečí je spolutvůrcem nového webu na ochranu občanů před kyberšmejdy

Oblíbené štítky

Výsledky projektu E-Bezpečí (2012-2024)

235000

+

proškolených žáků ZŠ a SŠ

90000

+

proškolených dospělých

8000

+

podpořených obětí kyberkriminality

300

+

vzdělávacích akcí ročně

7800

+

odhalených případů kyberkriminality

160000

+

unikátních návštěvníků webu ročně

Ocenění projektu E-Bezpečí

KYBER Cena 2023

(1. místo)

Nejlepší projekt prevence kriminality na místní úrovni 2023

(1. místo)

Evropská cena prevence kriminality 2015

(1. místo)

KYBER Cena 2023

(1. místo)

Nejlepší projekt prevence kriminality na místní úrovni 2023

(1. místo)

Evropská cena prevence kriminality 2015

(1. místo)

E-BEZPEČÍ: AI CHATBOT

xAhoj, jsem chatovací robot projektu E-Bezpečí a mohu ti pomoci zodpovědět základní otázky a vyřešit tvé problémy. Zvol si z nabídky, nebo svůj dotaz napiš přímo do chatu.

MÁM PROBLÉM

ZAJÍMÁ MĚ VZDĚLÁVÁNÍ

ZAJÍMAJÍ MĚ TISKOVINY

Trivium

Trivium Pravda a lež v online světě

Pravda a lež v online světě Samova dobrodružství 1

Samova dobrodružství 1